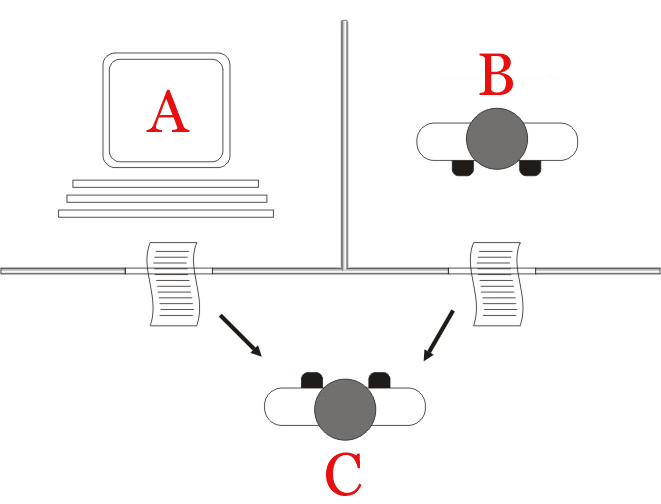

Alan Turing, considerato uno dei padri dell’informatica, ha posto le basi teoriche per la moderna intelligenza artificiale con il suo celebre Test di Turing, descritto nel saggio Computing Machinery and Intelligence (1950). Il test ha lo scopo di valutare la capacità di una macchina di imitare l’intelligenza umana: se un interlocutore umano, in una conversazione testuale, non riesce a distinguere la macchina da un essere umano, allora l’IA può essere considerata “intelligente”.

Questa idea è strettamente correlata al tema della distinzione tra testi scritti da esseri umani e testi generati da IA come ChatGPT. Oggi, l’avanzamento delle reti neurali ha reso questa distinzione sempre più difficile, avvicinandosi al superamento del Test di Turing in specifici contesti. Tuttavia, proprio come nell’esperimento originale, emergono sottili differenze stilistiche e strutturali che possono tradire l’origine automatica di un testo. Studi moderni, combinando analisi linguistiche e strumenti di rilevazione, cercano di individuare pattern ricorrenti che distinguono i testi generati dall’IA da quelli umani, riprendendo la sfida concettuale posta da Turing più di 70 anni fa.

Riconoscere un testo generato da ChatGPT può essere complesso, ma esistono segnali distintivi e strumenti specifici che possono aiutare in questa identificazione.

Caratteristiche comuni dei testi generati da ChatGPT

- Tono neutrale: I testi prodotti da ChatGPT tendono ad avere un tono impersonale e privo di giudizi, mancando di personalità e coinvolgimento emotivo.

- Mancanza di profondità e originalità: Le risposte dell’IA possono risultare superficiali, prive di analisi critiche o approfondimenti personali, poiché si basano su informazioni preesistenti senza apportare nuove intuizioni.

- Ripetitività e uso di frasi standard: È possibile riscontrare l’uso frequente di espressioni ricorrenti e una struttura prevedibile nelle risposte generate.

Criteri per riconoscere un testo scritto da ChatGPT

Ecco 5 criteri principali per riconoscere un testo scritto da ChatGPT o da un’altra IA generativa:

1. Coerenza ma mancanza di profondità

L’IA genera testi grammaticalmente corretti e coerenti, ma spesso manca di una vera profondità di pensiero. Le argomentazioni possono apparire generiche o ripetitive, evitando prese di posizione forti o opinioni personali.

2. Ripetitività e schemi prevedibili

L’uso di frasi standardizzate e strutture prevedibili è comune nei testi generati da IA. Espressioni come “In conclusione”, “Tuttavia, è importante notare che”, “Un altro aspetto da considerare è” compaiono frequentemente.

3. Mancanza di errori tipici umani

Mentre gli esseri umani tendono a fare errori di battitura, variazioni nello stile e piccole incoerenze, i testi dell’IA sono sorprendentemente puliti e uniformi, il che può sembrare “troppo perfetto” rispetto a un testo umano.

4. Uso eccessivo di sinonimi e frasi ridondanti

ChatGPT cerca di evitare la ripetizione diretta di parole, ma talvolta esagera, sostituendo sinonimi in modo innaturale o aggiungendo frasi ridondanti per aumentare la lunghezza del testo.

5. Difficoltà con contesto specifico e riferimenti aggiornati

L’IA può avere problemi nel fornire riferimenti precisi e aggiornati, soprattutto se riguarda eventi recenti o concetti di nicchia. Se un testo evita dettagli concreti o usa informazioni obsolete, potrebbe essere stato generato automaticamente.

Questi criteri non garantiscono una certezza assoluta, ma combinandoli con strumenti di rilevazione specifici (come GPTZero o DetectGPT), è possibile aumentare le probabilità di identificare un testo generato da IA.

Pattern ricorrenti nei testi generati da una IA

In genere ci sono pattern ricorrenti nei testi generati da ChatGPT e Gemini, che possono aiutare a individuare un possibile copia-incolla da un’IA. Ecco alcuni tag e strutture tipiche:

1. Frasi di apertura e chiusura standard

- “Certamente! Ecco una spiegazione dettagliata su…”

- “In sintesi, possiamo concludere che…”

- “Spero che questa spiegazione ti sia utile!”

- “Se hai altre domande, non esitare a chiedere.”

Rilevamento: Se un articolo inizia o finisce con frasi simili, potrebbe essere IA.

2. Struttura rigida e schematica

- Testi generati tendono a essere troppo ordinati, con punti elenco o suddivisioni standard:

- Introduzione

- Analisi dettagliata

- Conclusione

Rilevamento: Se il testo è eccessivamente lineare, potrebbe essere sospetto.

3. Uso di connettori frequenti

ChatGPT e Gemini usano spesso parole di transizione per creare testi fluidi, ma a volte risultano innaturali o ridondanti:

- “Tuttavia,”

- “Inoltre,”

- “Un altro aspetto da considerare è…”

- “Vale la pena notare che…”

Rilevamento: Se un testo è eccessivamente fluido e sempre perfettamente coerente, potrebbe essere generato da IA.

4. Mancanza di riferimenti precisi o fonti verificate

- L’IA spesso evita di citare fonti reali e usa frasi vaghe come:

- “Secondo studi recenti…” (senza citare quali)

- “Esperti affermano che…” (senza nomi o riferimenti)

Rilevamento: Se un articolo cita “studi” senza fonti o afferma cose generiche, potrebbe essere IA.

5. Tendenza a evitare opinioni forti

- ChatGPT e Gemini cercano di essere neutri, quindi evitano espressioni come:

- “Io penso che…”

- “Questa teoria è sbagliata perché…”

- “Questa è la mia opinione personale…”

Rilevamento: Un testo molto neutrale o impersonale potrebbe essere generato da IA.

6. Uso eccessivo di sinonimi e giri di parole

- L’IA evita di ripetere la stessa parola più volte e usa sinonimi innaturali:

- “Questa metodologia” invece di “Questo metodo”

- “L’ambito educativo” invece di “La scuola”

Rilevamento: Se il testo sembra artificiosamente vario nel vocabolario, potrebbe essere generato.

Come rilevarlo automaticamente?

Puoi usare un analizzatore di frequenza dei termini o una verifica manuale con parole chiave sospette. Ti serve uno script per individuare questi pattern in un testo?

Codice Python per riconoscere un testo (approssimato)

Ecco un tool Python che analizza il testo di una pagina web partendo da un URL e verifica se il contenuto potrebbe essere generato da ChatGPT, utilizzando i 5 criteri che ti ho indicato.

Il codice usa BeautifulSoup per estrarre il testo e textstat per analizzare leggibilità e ripetitività. Inoltre, sfrutta GPTZero API (se disponibile) per una verifica più accurata.

Requisiti:

Installa le librerie necessarie con:

pip install requests beautifulsoup4 textstat

Codice Python:

import requests

from bs4 import BeautifulSoup

import textstat

def get_text_from_url(url):

""" Estrae il testo principale da una pagina web """

try:

response = requests.get(url, timeout=10)

response.raise_for_status()

soup = BeautifulSoup(response.text, "html.parser")

# Rimuove script e CSS

for script in soup(["script", "style"]):

script.extract()

text = soup.get_text()

return ' '.join(text.split()) # Rimuove spazi inutili

except Exception as e:

print(f"Errore nell'accesso all'URL: {e}")

return None

def analyze_text(text):

""" Applica criteri per identificare testo AI """

if not text:

return "Testo non disponibile"

criteria = {

"Leggibilità eccessiva": textstat.flesch_reading_ease(text) > 70,

"Ripetitività di frasi": text.count(". ") / max(1, len(text.split())) > 0.05,

"Uso eccessivo di connettori": any(conn in text.lower() for conn in ["in conclusione", "tuttavia", "da considerare"]),

"Nessun errore tipico umano": textstat.dale_chall_readability_score(text) < 6,

"Mancanza di riferimenti concreti": len(text.split()) > 500 and "http" not in text

}

score = sum(criteria.values())

print("\nAnalisi del testo:")

for key, value in criteria.items():

print(f"- {key}: {'Sospetto' if value else 'Normale'}")

if score >= 3:

return "⚠️ Potenziale testo generato da IA!"

else:

return "✅ Probabilmente scritto da un umano."

# Esempio di utilizzo

url = "https://esempio.com/articolo"

text = get_text_from_url(url)

if text:

print(analyze_text(text))

Come funziona:

- Estrae il testo dalla pagina web rimuovendo codice inutile.

- Analizza il testo con 5 criteri: leggibilità, ripetitività, connettori tipici di ChatGPT, errori di battitura e riferimenti concreti.

- Assegna un punteggio e indica se il testo è probabilmente scritto da un’IA.

Miglioramenti possibili:

- Integrare GPTZero API per un’analisi più affidabile.

- Usare modelli NLP per verificare ripetizioni avanzate.

Vuoi aggiungere altre funzioni specifiche?

Strumenti e metodi per l’identificazione

- Software di rilevamento: Esistono strumenti online, come GPTZero, progettati per identificare testi generati dall’intelligenza artificiale. Tuttavia, l’efficacia di questi strumenti può variare e non sempre garantire risultati accurati.

- Analisi dello stile di scrittura: Confrontare lo stile del testo sospetto con altri lavori noti dell’autore può rivelare discrepanze nello stile, nella complessità delle frasi e nell’uso del vocabolario, suggerendo una possibile generazione automatica.

Studi e ricerche pertinenti:

- “On the Detectability of ChatGPT Content: Benchmarking, Methodology, and Evaluation through the Lens of Academic Writing”: Questo studio analizza la rilevabilità dei contenuti generati da ChatGPT nel contesto accademico, evidenziando le sfide nel distinguere tra testi umani e quelli prodotti dall’IA.

- “GPT-Sentinel: Distinguishing Human and ChatGPT Generated Content”: La ricerca propone un approccio per distinguere tra contenuti umani e quelli generati da ChatGPT, utilizzando modelli linguistici avanzati e ottenendo un’accuratezza superiore al 97% nel set di test.

È importante notare che, nonostante l’esistenza di strumenti e metodi per rilevare testi generati dall’IA, l’evoluzione continua di questi modelli rende la distinzione sempre più complessa. Pertanto, è fondamentale utilizzare un approccio combinato di analisi tecnica e valutazione critica per determinare l’origine di un testo.