Le moderne intelligenze artificiali come GPT-4, Copilot e Gemini hanno capacità straordinarie, ma spesso capita che diano risposte inesatte, imprecise o persino contraddittorie. Perché succede? La chiave sta nel modo in cui queste AI funzionano: i loro output non sono deterministici, ma probabilistici. Deterministico si intende qui che le risposte sono determinabili passo-passo, senza incertezze, mentre nel modello probabilistico si introduce per maggiore flessibilità una risposta che rimane incerta nel tempo, e che potrebbe in alcuni casi fuorviare.

Si tratta di strumenti che per la creatività possono funzionare meglio di quanto possa sembrare, al netto delle note questioni legate agli scarsi controlli del copyright. Se io chiedessi, ad esempio:

Domanda: “Scrivi una poesia su un gatto.”

Risposta 1:

“Il gatto sornione guarda la luna,

Sogna avventure, ma resta in cuna.”

Risposta 2:

“Tra i tetti danza leggero e felino,

Notturno re, nel buio divino.”

In questo caso ogni generazione sarà diversa, perché l’IA non ha un testo fisso ma crea combinazioni probabilistiche di parole.

Come secondo esempio se chiediamo a un’IA di tradurre dall’inglese all’italiano:

Testo originale: “The meeting was a success.”

Risposta 1: “L’incontro è stato un successo.”

Risposta 2: “La riunione è andata bene.”

Entrambe sarebbero corrette, per quanto la seconda sia meno letterale. L’IA non ha una “verità assoluta”, ma sceglie una formulazione basata sulle probabilità apprese durante l’addestramento.

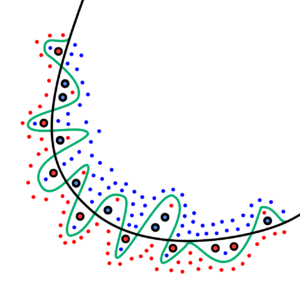

L’architettura Transformer

Tutti i modelli di LLM avanzati si basano sull’architettura Transformer, introdotta nel paper “Attention is All You Need” (Vaswani et al., 2017). Questo sistema ha rivoluzionato l’elaborazione del linguaggio naturale (NLP), permettendo alle macchine di comprendere e generare testo in modo molto più efficace rispetto alle vecchie reti neurali ricorrenti (RNN, LSTM).

Il modello elabora il testo utilizzando una tecnica chiamata self-attention, che gli permette di analizzare contemporaneamente tutte le parole di una frase e capire il contesto globale. In pratica:

- Non “legge” il testo parola per parola, ma considera tutte le possibili relazioni tra i termini.

- Non ha una memoria fissa, ma si basa sulle informazioni statistiche apprese durante l’addestramento su enormi dataset.

- Non genera risposte in modo deterministico, ma sceglie ogni parola in base a una distribuzione di probabilità.

Ad esempio:

Domanda: “Qual è il miglior film di tutti i tempi?”

Risposta 1: “Molti considerano ‘Il Padrino’ come il miglior film.”

Risposta 2: “‘Shawshank Redemption’ è spesso al primo posto nelle classifiche.”

Risposta 3: “Dipende dai gusti: alcuni preferiscono ‘Casablanca’ o ‘2001: Odissea nello spazio’.”

➡ Il modello in questo caso non ha un’unica risposta, perché dipende dalle opinioni e dai dati con cui è stato addestrato.

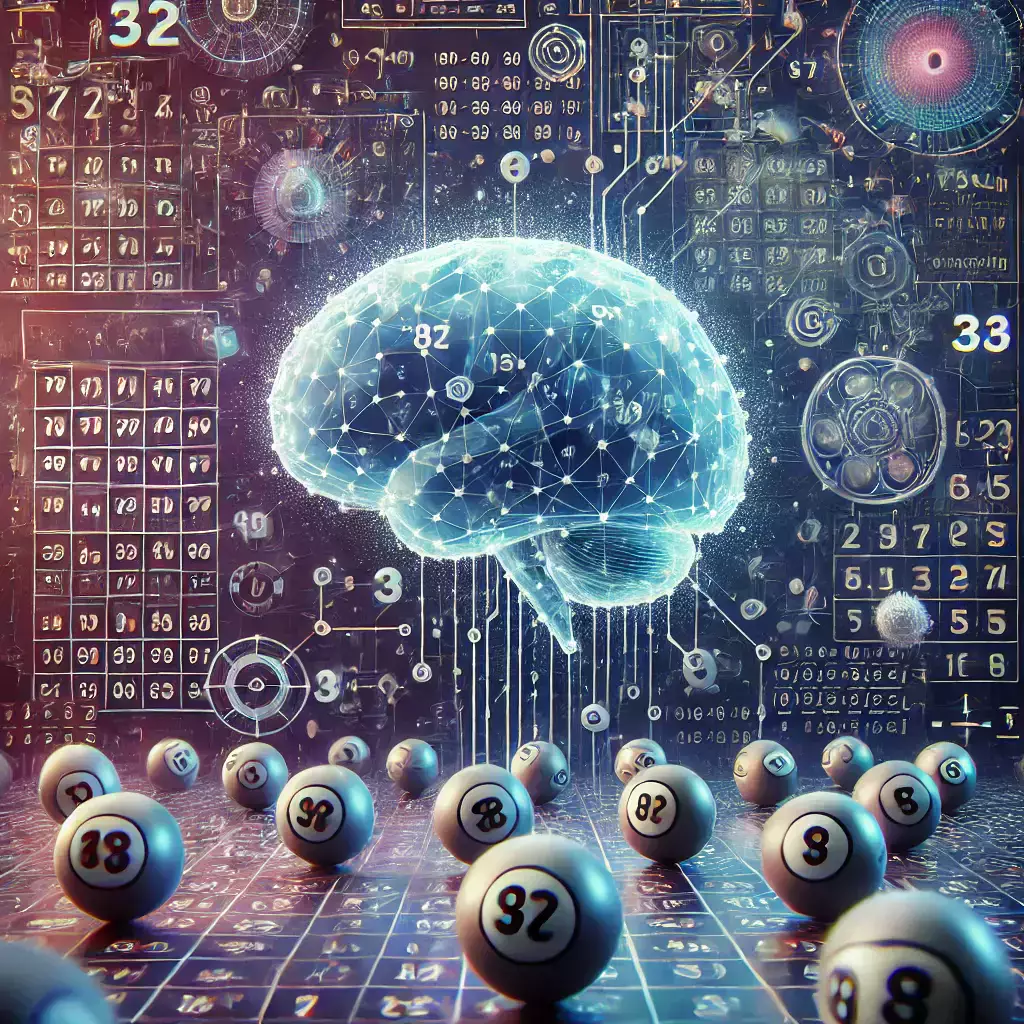

Perché le risposte delle IA sono probabilistiche?

Anche i modelli più avanzati non forniscono risposte certe, ma solo le più probabili in base ai dati su cui sono stati addestrati. Questo accade per diversi motivi:

- Scelta probabilistica dei token

- Quando una IA genera una frase, non sta “recuperando” una risposta da un archivio, ma prevede parola dopo parola quale sia la più probabile successiva.

- Se chiedo “Qual è la capitale della Francia?”, la parola “Parigi” avrà una probabilità del 99%, mentre “Marsiglia” dello 0,1%.

- Ma se chiedo qualcosa di meno definito, come “Qual è il miglior film di sempre?”, il modello non ha un’unica risposta corretta e darà risposte diverse ogni volta.

- Il dataset di addestramento è vasto, ma imperfetto

- Le IA sono addestrate su miliardi di testi provenienti da internet, libri e articoli, ma i dati contengono errori, opinioni contrastanti e informazioni obsolete.

- Il modello non sa cosa sia vero, ma solo cosa è più probabile.

- Parametri di generazione che influenzano la casualità

- Il comportamento dell’IA dipende da impostazioni come la temperature:

- Se è bassa (0.1), la IA darà risposte più rigide e prevedibili.

- Se è alta (1.5), la IA esplorerà anche opzioni meno probabili, risultando più “creativa”, ma anche più imprecisa.

- Il comportamento dell’IA dipende da impostazioni come la temperature:

- Anche i modelli con ragionamento avanzato sono probabilistici

- Sistemi come DeepSeek-MoE usano il meccanismo Mixture-of-Experts, che divide i compiti tra più “esperti” interni, migliorando le prestazioni.

- Tuttavia, anche in questi casi, il principio non cambia: le risposte sono sempre probabilistiche e possono variare a seconda del contesto e dei dati disponibili.

Domanda: “Qual è la capitale dell’Australia?”

Risposta corretta: “Canberra.”

Risposta errata (ma possibile): “Sydney.”

➡ Se il modello ha visto più volte “Sydney” associata all’Australia, potrebbe generare un errore dovuto alla maggiore frequenza di quel termine nei dati.

Le IA non sono oracoli, bensì calcolatori di probabilità

Se un’IA sbaglia, non è perché “non ha capito”, ma perché sta scegliendo tra diverse possibilità, basandosi su probabilità e non su certezze.

Fonti pubbliche per approfondire:

- “Attention is All You Need” (Vaswani et al., 2017)

- “Scaling Laws for Neural Language Models” (Kaplan et al., 2020)

- Blog di OpenAI, DeepMind, Google AI, Meta AI.

Quindi, la prossima volta che un’IA non ci azzecca, ricordiamoci che non sta “sapendo”, ma solo “prevedendo” la risposta più probabile.